一、先理解优点

Adam优化器

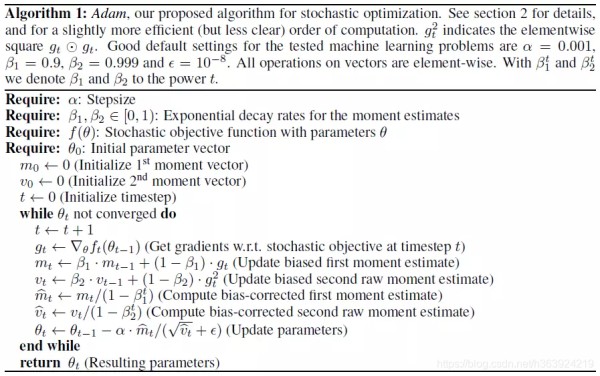

2014年12月,Kingma和Lei Ba两位学者提出了Adam优化器,结合AdaGrad和RMSProp两种优化算法的优点。对梯度的一阶矩估计(First Moment Estimation,即梯度的均值)和二阶矩估计(SecondMoment Estimation,即梯度的未中心化的方差)进行综合考虑,计算出更新步长。

主要包含以下几个显著的优点:

综合Adam在很多情况下算作默认工作性能比较优秀的优化器。

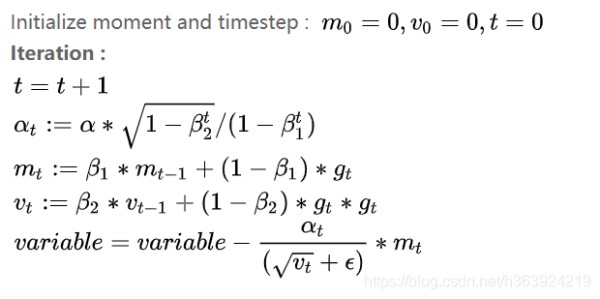

二、记录下公式

三、伪代码

四、问题及改进

虽然Adam算法目前成为主流的优化算法,不过在很多领域里(如计算机视觉的对象识别、NLP中的机器翻译)的最佳成果仍然是使用带动量(Momentum)的SGD来获取到的。Wilson 等人的论文结果显示,在对象识别、字符级别建模、语法成分分析等方面,自适应学习率方法(包括AdaGrad、AdaDelta、RMSProp、Adam等)通常比Momentum算法效果更差。

针对Adam等自适应学习率方法的问题,主要两个方面的改进:

1、解耦权重衰减

在每次更新梯度时,同时对其进行衰减(衰减系数w略小于1),避免产生过大的参数。

在Adam优化过程中,增加参数权重衰减项。解耦学习率和权重衰减两个超参数,能单独调试优化两个参数。

2、修正指数移动均值

最近的几篇论文显示较低的[if !msEquation][endif](如0.99或0.9)能够获得比默认值0.999更佳的结果,暗示出指数移动均值本身可能也包含了缺陷。例如在训练过程中,某个mini-batch出现比较大信息量的梯度信息,但由于这类mini-batch出现频次很少,而指数移动均值会减弱他们的作用(因为当前梯度权重及当前梯度的平方的权重,权重都比较小),导致在这种场景下收敛比较差。

AMSGrad 使用最大的来更新梯度,而不像Adam算法中采用历史的指数移动均值来实现。作者在小批量数据集及CIFAR-10上观察到比Adam更佳的效果。