【科技前沿】用深度强化学习优化电网,让电力调度更聪明!

使用强化学习优化深度神经网络的决策策略 #生活技巧# #学习技巧# #深度学习技巧#

Hey小伙伴们,今天我要跟大家分享一个超级酷炫的技术应用——深度强化学习在电网优化中的典型案例!如果你对机器学习感兴趣,或是正寻找如何用AI技术解决实际问题的方法,这篇分享绝对不容错过!✨

开场白

大家好,我是你们的技术小助手!今天我们要聊的是如何利用深度强化学习(DRL)来优化电网的调度,让电力系统变得更智能、更高效。

引入话题

想象一下,如果你能够通过一种先进的技术手段,自动调整电网中的能源分配,不仅能够节约成本,还能确保电力供应的稳定性,那该有多好?今天我们就来揭秘这个神奇的技术——深度强化学习!

主体内容

1. 什么是深度强化学习?应用场景:

深度强化学习是一种结合了深度学习和强化学习的方法,它能让计算机通过与环境的互动学习到最优的行为策略。

优势:

自适应性强:能够根据环境的变化自动调整策略。通用性好:适用于多种复杂场景下的决策问题。 2. 电网优化案例背景应用场景:

在电网管理中,如何合理调度电力资源是一项极具挑战的任务。我们需要确保电力供应稳定的同时,还要尽量降低成本。

问题描述:

假设我们有一个小型电网系统,其中包括风力发电、太阳能发电和储能装置。我们的目标是通过调整不同类型的发电设施的功率输出,以及储能装置的充放电策略,来满足电网的需求,同时尽量减少总成本。

应用场景:

我们使用深度强化学习中的DQN(Deep Q-Network)算法来训练一个代理,使其能够学习到最优的调度策略。

代码解析:

首先,我们需要安装必要的库:

pip install gymnasium stable-baselines3 1

接着,我们定义一个简单的环境,并训练一个DQN代理。

定义环境import gymnasium as gym import numpy as np from stable_baselines3 import DQN from stable_baselines3.common.env_checker import check_env from stable_baselines3.common.evaluation import evaluate_policy # 定义环境类 class GridEnv(gym.Env): metadata = {'render_modes': ['human']} def __init__(self): super(GridEnv, self).__init__() self.action_space = gym.spaces.Discrete(3) # 0: charge battery, 1: idle, 2: discharge battery self.observation_space = gym.spaces.Box(low=-np.inf, high=np.inf, shape=(3,), dtype=np.int32) # Demand, Battery Level, Cost self.demand = 0 # 当前需求 self.battery_level = 50 # 初始电池电量 (0-100%) self.cost = 0 # 当前成本 self.max_steps = 100 self.current_step = 0 def reset(self, *, seed=None, options=None): super().reset(seed=seed) self.demand = np.random.randint(20, 80) self.battery_level = 50 self.cost = 0 self.current_step = 0 return np.array([self.demand, self.battery_level, self.cost]), {} def step(self, action): if action == 0: # 充电 self.battery_level = min(100, self.battery_level + 10) self.cost += 10 elif action == 2: # 放电 self.battery_level = max(0, self.battery_level - 10) self.cost -= 10 self.current_step += 1 reward = -self.cost terminated = self.current_step >= self.max_steps truncated = False # 假设没有截断 info = {} # 更新需求 self.demand = np.random.randint(20, 80) return np.array([self.demand, self.battery_level, self.cost]), reward, terminated, truncated, info def render(self, mode='human'): print( f"Step: {self.current_step}, Demand: {self.demand}, Battery Level: {self.battery_level}, Cost: {self.cost}") def close(self): pass

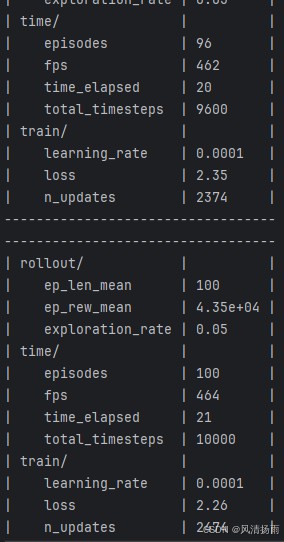

1234567891011121314151617181920212223242526272829303132333435363738394041424344454647484950515253545556 训练DQN模型# 创建环境实例 env = GridEnv() # 检查环境 check_env(env) # 初始化模型 model = DQN('MlpPolicy', env, verbose=1) # 训练模型 model.learn(total_timesteps=10000) # 保存模型 model.save("grid_optimization_model") # Evaluate the model mean_reward, std_reward = evaluate_policy(model, env, n_eval_episodes=10) print(f"Mean reward: {mean_reward:.2f} +/- {std_reward:.2f}")

1234567891011121314151617 使用模型# 使用模型 model = DQN.load("grid_optimization_model") # 重置环境 obs, _ = env.reset() # 注意这里返回obs和info # 运行环境 for i in range(100): action, _states = model.predict(obs, deterministic=True) obs, rewards, dones, truncated, infos = env.step(action) env.render() # 关闭环境 env.close() 1234567891011121314 4. 成果展示

通过训练好的DQN模型,我们能够自动调整电网中的能量分配策略,以最小化成本并保持供需平衡。这不仅提高了电网的运行效率,还能帮助我们更好地利用可再生能源。

实战应用

【实战代码片段】

上面的代码已经展示了如何在电网优化中使用深度强化学习。你可以尝试修改环境参数或增加更多的训练周期来观察不同的效果。

结尾

好了,今天的分享就到这里。希望你能喜欢这个关于深度强化学习在电网优化中的案例!如果你觉得有趣的话,别忘了点赞、关注和转发哦!咱们下期见!

#深度强化学习 #电网优化 #科技前沿

如果你有任何疑问或需要进一步的帮助,请随时留言告诉我,我会尽力为你解答!✨

网址:【科技前沿】用深度强化学习优化电网,让电力调度更聪明! https://www.yuejiaxmz.com/news/view/274075

相关内容

智能电网与电力系统调度优化研究智能电网——聪明的电网不浪费一度电

智能家电,让生活更“智慧” 家电网® HEA深度原创

使用Python实现深度学习模型:智能家电控制与优化

深度学习中的优化问题(Optimization)

【优化调度】基于多时间尺度的电动汽车光伏充电站联合分层优化调度附Matlab代码

基于深度学习的电子商务个性化推荐模型

基于ADMM的智能电网电力调度优化分布式在线算法

Dropout技术全面解析——深度学习中的泛化能力提升策略

【ML4CO论文精读】基于深度强化学习的组合优化问题研究进展(李凯文, 2020)