基于强化学习的智能家居能源管理

利用智能家居,实现能源管理的智能化 #生活知识# #家居生活# #居家生活哲学# #绿色环保家居#

1. 研究背景与目标

智能电网(Smart Grid,SG)作为下一代电力系统,其特点是在电能的生产、传输、分配和消费过程中广泛应用信息通信技术(如物联网)。在智能电网环境中,智能家居为节省能源成本提供了诸多机会。

暖通空调(Heating, Ventilation, and Air Conditioning,HVAC)系统在家庭中的能耗占比约为40%。考虑到HVAC系统的主要目的是维持居住者的热舒适度,在不牺牲热舒适度的前提下优化智能家居的能源成本具有重要意义。

本研究旨在解决一个智能家居能源优化问题。研究目标是在考虑舒适室内温度范围的情况下,在缺乏建筑热动力学模型的条件下,最小化智能家居在一定时间范围内的能源成本。然而,实现这一目标面临以下挑战:

室内温度动态受多种因素影响,难以获得准确的动态模型。

难以掌握所有随机系统参数(如可再生能源发电输出、不可移动负载需求、室外温度和电价)的统计分布。

存在与能量存储系统(Energy Storage System,ESS)和HVAC系统相关的时间耦合操作约束,这意味着当前的行动会影响未来的决策。

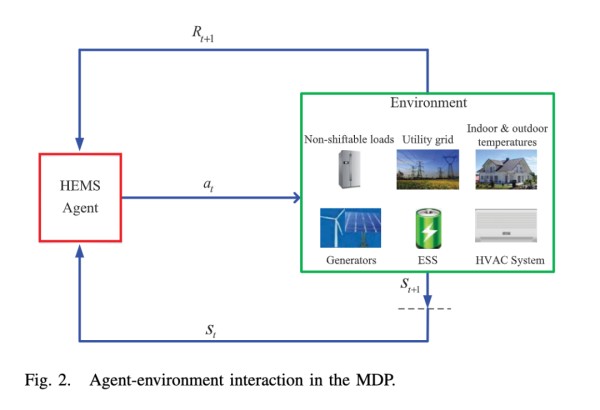

为应对这些挑战,研究团队首先将上述问题建模为马尔可夫决策过程(Markov Decision Process,MDP),然后提出了一种基于深度确定性策略梯度(Deep Deterministic Policy Gradients,DDPG)的能源管理算法。

2. 系统模型与问题formulation

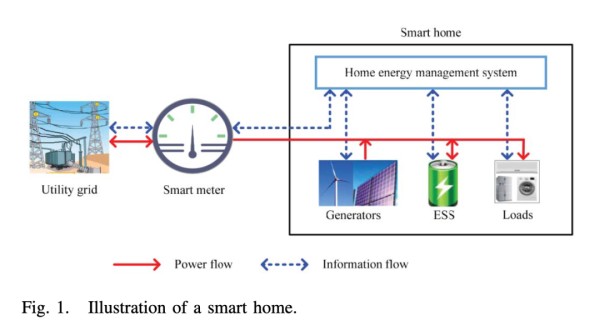

本研究考虑的智能家居系统如图1所示,包括分布式发电设备、能量存储系统、负载和家庭能源管理系统(Home Energy Management System,HEMS)。

分布式发电设备可以是太阳能电池板或风力发电机。ESS可以是铅酸电池或锂离子电池,通过本地存储过剩的可再生能源来减少主电网的净能源需求,对于未来实现近零能耗建筑至关重要。

智能家居中的负载可以大致分为几类:不可移动负载、可移动且不可中断负载和可控负载。本研究主要关注不可移动负载和热力可控负载,其中HVAC系统作为主要的热力可控负载。

家庭能源管理系统在每个时间槽根据可用信息(如可再生能源发电输出、不可移动负载需求、室外温度和电价)对ESS充放电功率和HVAC输入功率做出连续决策,目的是最小化智能家居的能源成本,同时在缺乏建筑热动力学模型的情况下维持舒适的温度范围。

系统模型包括ESS存储动态模型、HVAC系统模型、功率平衡约束和成本模型。ESS存储动态模型描述了ESS中存储能量的变化,考虑了充放电效率和功率限制。HVAC系统模型定义了舒适温度范围和输入功率限制。功率平衡约束确保总供电功率等于所服务的负载功率。成本模型包括能源成本和ESS折旧成本。

基于上述模型,总能源成本最小化问题可以构建为在满足各项约束条件下最小化期望总成本。这个优化问题考虑了系统参数的随机性和可能的随机控制动作。

3. 基于深度确定性策略梯度的能源管理算法

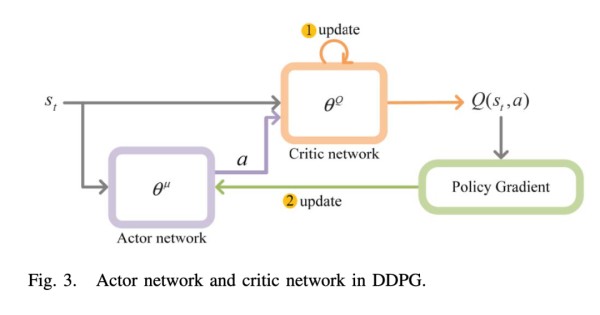

为解决上述MDP问题,研究团队提出了一种基于DDPG的能源管理算法。与深度Q网络(Deep Q-Network,DQN)不同,DDPG能够处理连续的状态和动作空间。

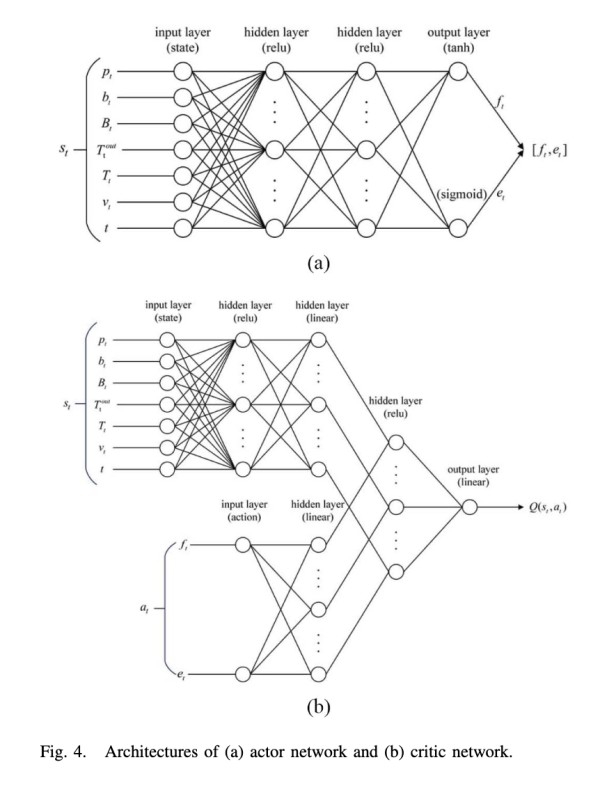

DDPG是一种actor-critic(演员-评论家)方法,包含actor网络和critic网络。图3展示了这两个网络的结构。

actor网络的输入是环境状态,输出是动作。critic网络的输入是环境状态和动作,输出是动作值函数。通过这两个网络的交互,可以计算策略梯度并用于更新actor网络的权重。

所提出的基于DDPG的能源管理算法包括两个主要部分:训练深度神经网络和能源管理策略。

在训练过程中,首先初始化回放内存,用于存储状态转换信息。然后随机初始化critic网络和actor网络的权重,并通过复制初始化目标网络的权重。在每个时间槽,根据当前策略选择动作并加入探索噪声,执行动作后观察新的状态和奖励,并将这些信息存储在回放内存中。

随后,从回放内存中随机采样一批数据用于训练网络。通过最小化均方误差损失函数更新critic网络的权重,计算采样策略梯度更新actor网络的权重,最后更新目标网络的权重。这个过程不断重复,直到达到预设的训练回合数。

在能源管理策略中,使用训练好的actor网络来选择动作。在每个时间槽,根据当前环境状态选择ESS充放电功率和HVAC输入功率的动作,执行这些动作并观察新的状态和奖励。

算法的计算复杂度主要取决于测试时隙数。由于每个时间槽内的计算较为简单,算法可以实时实施。然而,时间槽持续时间的选择需要权衡控制机会和训练收敛性。在实际应用中,典型的时间槽持续时间为几分钟到一小时。

4. 性能评估

4.1 仿真设置仿真使用了来自Pecan Street数据库的真实数据,包括太阳能发电、不可移动负载需求、室外温度和电价。该数据库包含了美国德克萨斯州奥斯汀市Mueller社区的家庭能源数据。考虑到奥斯汀夏季非常炎热,研究使用了2018年6月1日至8月31日的数据进行模型训练和测试。

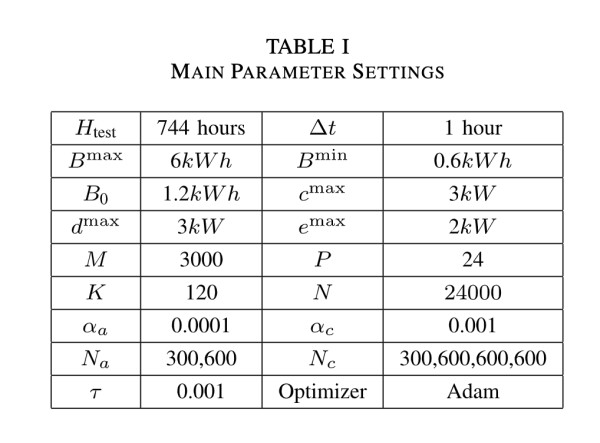

主要系统参数配置如表1所示。为模拟环境,采用了简化的室内温度动态模型。需要注意的是,所提出的能源管理算法的变体可以适用于任何室内温度动态模型,只需在系统状态中纳入更多环境相关变量。

为评估所提出算法的性能,采用了三个基准方案:

基准方案1:采用ON/OFF策略进行HVAC控制,不考虑ESS的使用。

基准方案2:使用本文提出的基于DDPG的控制策略进行HVAC控制,不考虑ESS的使用。

基准方案3:假设所有不确定系统参数和室内温度动态模型都可以事先知道,最小化测试期间的累积成本。

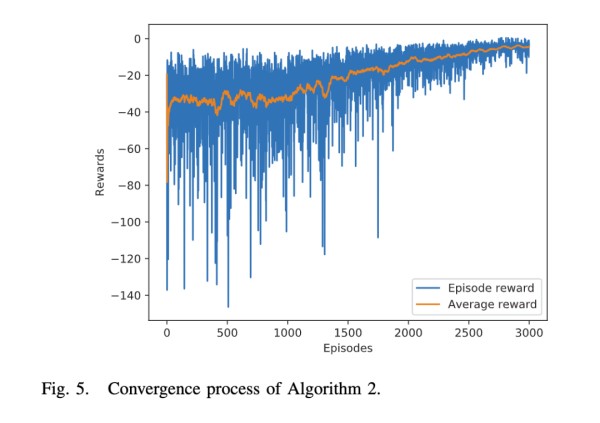

4.3 仿真结果 4.3.1 算法收敛过程图5展示了算法训练过程中每个回合接收到的奖励变化趋势。总体上,奖励呈上升趋势,但由于探索和系统参数的随机性,存在一定波动。

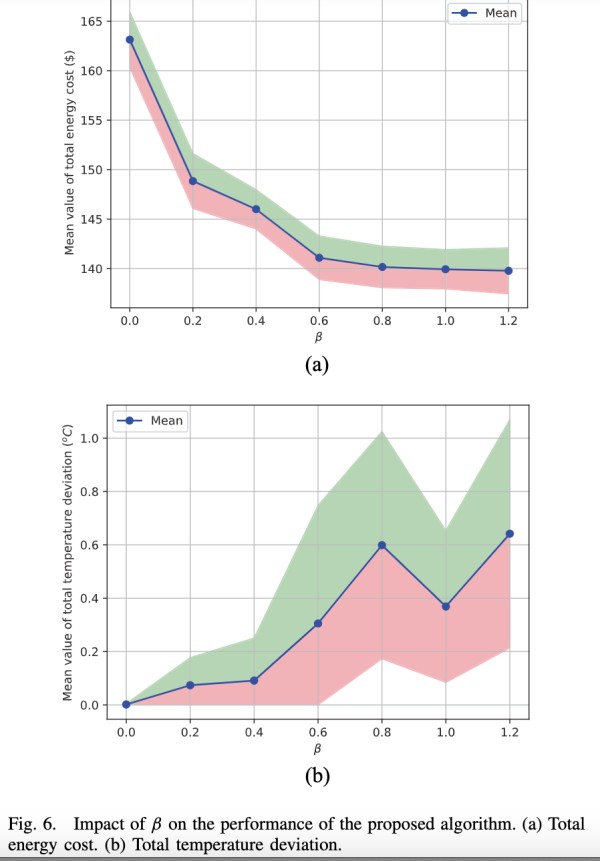

图6显示了β参数对总能源成本和总温度偏差的影响。随着β的增加,总能源成本的平均值总体呈下降趋势,而总温度偏差的平均值总体呈上升趋势。这是因为较大的β值会增加能源成本的重要性,降低温度偏差的重要性。

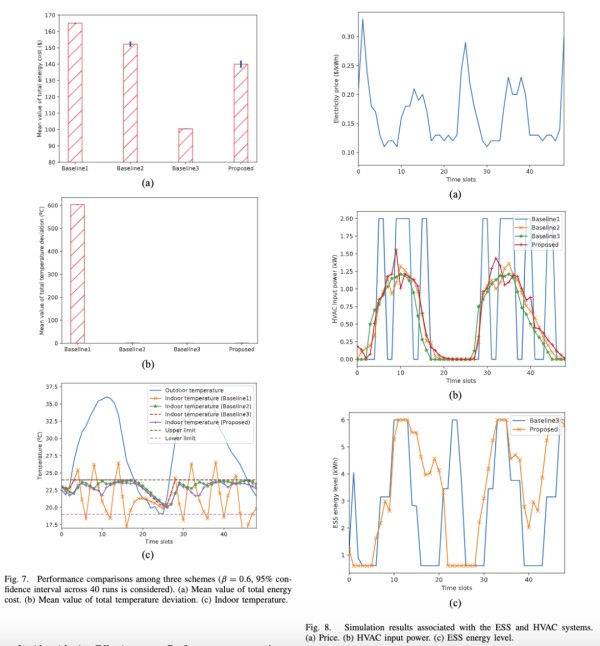

图7展示了四种方案的性能比较。所提出的能源管理算法在总能源成本和温度控制方面都优于基准方案1和基准方案2。具体而言,与基准方案1和基准方案2相比,所提出的算法分别将总能源成本的平均值降低了15.21%和8.10%。

图8进一步说明了所提出算法的优势。与基准方案1相比,基准方案2和所提出的算法可以根据电价变化调整HVAC输入功率。与基准方案2相比,所提出的算法还可以通过ESS的充放电进一步优化能源使用。

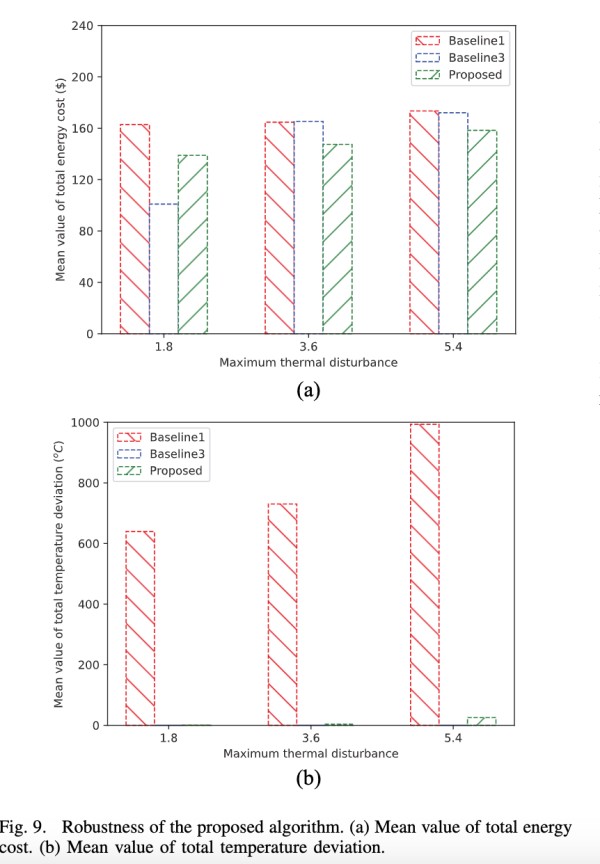

4.3.4 算法鲁棒性为评估算法的鲁棒性,研究团队在温度模型中引入了随机热扰动。图9显示了在不同扰动强度下算法的性能。结果表明,所提出的算法在各种情况下都比基准方案1表现更好,并且在总温度偏差略有增加的情况下能够显著节省能源成本。

5. 结论与未来展望

本研究提出了一种基于DDPG的能源管理算法,用于在缺乏建筑热动力学模型的情况下有效控制智能家居中的HVAC系统和ESS。仿真结果显示了所提出算法的有效性和鲁棒性。

未来研究方向包括采用更全面的热舒适度模型,考虑电动汽车和电热水器等更多类型的可控负载,利用真实世界的居住者行为信息优化控制策略,以及改进算法以适应多房间、多区域的HVAC控制等复杂场景。同时,需要在实际智能家居系统中实施和验证算法,探索多智能体强化学习方法以适应更大规模场景,增强算法的可解释性以提高用户信任度,并重视智能家居系统的隐私和安全问题。这些研究方向将有助于开发出更智能、高效和实用的家庭能源管理系统,为建设可持续的智能城市做出贡献。

网址:基于强化学习的智能家居能源管理 https://www.yuejiaxmz.com/news/view/640754

相关内容

基于强化学习的综合能源系统管理综述强化学习在能源领域的应用:智能能源管理与节能优化

基于智能家居的一体化能效管理体系的构建

强化学习在能源领域的应用:智能能源管理与节能优化1.背景介绍 能源资源是国家和社会的基本生产力和生活基础。在全球化的背景

智能家居的能源管理

基于智能电能表的智能家居能源管理系统设计

基于嵌入式系统的智能能源管理系统

基于智能算法的智能家居系统设计与优化

家庭能源管理中的机器学习

基于ZigBee的智能家居能源管理系统设计与实现