探析可解释人工智能 (XAI) 方法在 GDPR 合规性中的应用

人工智能在医疗影像分析中的应用 #生活知识# #科技生活# #科技改变生活# #智能医疗#

1. 引言

人工智能 (AI) 正迅速渗透到我们生活的方方面面,并在各个领域展现出巨大的潜力。尤其是在信贷、住房和医疗等高风险领域,AI驱动的自动化决策 (ADM) 系统正发挥着越来越重要的作用。这些系统能够高效地处理海量数据,并根据预设算法做出决策,从而提高效率、降低成本。然而,ADM 系统的广泛应用也引发了人们对其透明度和问责制的担忧。由于许多 ADM 系统基于复杂的机器学习模型,例如深度神经网络,其决策过程往往难以理解,甚至可能存在算法偏差和歧视等问题,这给个人权益带来了潜在风险。

为了解决 ADM 系统的"黑盒"问题,可解释人工智能 (XAI) 应运而生。XAI 旨在提供各种方法来解释复杂模型的决策过程,使人们能够理解 AI 如何做出决策,并评估其公平性和可靠性。XAI 不仅有助于提高用户对 AI 系统的信任度,还有助于识别和纠正算法偏差,确保 AI 系统的负责任使用。

欧盟的《通用数据保护条例》(GDPR) 对数据隐私和个人权利进行了严格的规定,其中包括对自动化决策的解释权的要求。GDPR 第 22 条及其相关条款规定,个人有权不被完全基于自动化处理(包括分析)的决策所约束,并且有权获得关于这些决策的解释。然而,GDPR 对解释权的具体内容和形式并没有明确规定,这给 XAI 方法的合规性带来了挑战。

为了探究 XAI 方法如何满足 GDPR 的要求,在论文《The explanation dialogues: an expert focus study to understand requirements towards explanations within the GDPR》中,比萨大学和南安普顿大学的研究者进行了一项专家焦点研究,旨在了解法律专家对 XAI 解释的理解、期望和推理。这项研究的结果将为 XAI 方法的开发和应用提供重要的指导,并有助于促进 AI 系统在 GDPR 框架下的合规性。

2. 背景与相关工作

2.1 GDPR 与自动化决策

GDPR 第 22 条规定,个人有权不被完全基于自动化处理的决策所约束,除非该决策: (1) 是订立或履行合同所必需的;(2) 基于数据主体的明确同意;(3) 是由欧盟或成员国法律授权的。此外,GDPR 还对特殊类别的个人数据(例如种族、政治观点、健康状况等)的自动化处理进行了更严格的限制。

即使满足上述例外情况,GDPR 仍然要求数据控制者采取适当的保障措施来保护数据主体的权益。这些保障措施包括: (1) 数据主体有权获得人工干预;(2) 数据主体有权表达自己的观点;(3) 数据主体有权对决策提出异议。此外,GDPR 第 71 条款还提到了数据主体有权获得对决策的解释。

然而,GDPR 对解释权的具体内容和形式并没有明确规定,这引发了关于其含义和范围的广泛讨论。一些学者认为,解释权是竞争权的前提,数据主体只有理解了决策的依据和逻辑,才能有效地行使竞争权。另一些学者则认为,解释权的范围应受到 GDPR 透明度原则的限制,数据控制者只需提供必要的信息,而无需透露其商业秘密或知识产权。

不同国家对 GDPR 第 22 条的实施也存在差异。例如,法国和匈牙利在其国内法中明确规定了对自动化决策的解释权,而其他一些国家则没有。这些差异反映了各国对 XAI 解释的不同理解和期望。

2.2 可解释人工智能 (XAI)

XAI 方法可以根据其解释范围和模型依赖性进行分类。局部解释方法旨在解释单个决策,而全局解释方法则旨在解释整个模型的行为。模型特定方法只能用于特定类型的模型,而模型无关方法则可以应用于任何类型的模型。

研究中使用了三种模型无关的局部解释方法:

SHAP (SHapley Additive exPlanations):SHAP 是一种基于博弈论的特征相关性方法,它可以计算每个特征对最终决策的贡献值。SHAP 值可以是正的也可以是负的,表示该特征对决策结果的正面或负面影响。DICE (DIverse Counterfactual Explanations):DICE 是一种对比解释方法,它可以生成与待解释实例相似但具有不同预测结果的实例。这些对比实例可以帮助用户理解如何改变输入特征以获得不同的决策结果。LORE (LOcal Rule-based Explanations):LORE 是一种基于规则的对比解释方法,它可以生成描述决策逻辑的规则。LORE 可以提供事实规则和对比规则,分别解释当前决策的依据和如何改变输入以获得不同决策。2.3 定性研究

XAI 中的用户研究旨在了解不同用户对 XAI 解释的理解、接受程度和使用方式。用户研究通常采用定性研究方法,例如调查、访谈和观察,以收集用户的反馈和意见。扎根理论是一种从定性数据中生成理论的分析方法。它通过对数据进行编码和分类,逐步提炼出核心概念和理论框架。

3. 解释对话

3.1 研究问题

研究旨在回答以下两个研究问题:

法律专家如何理解 ADM 系统的解释,以及他们如何判断现有方法的法律合规性?法律专家是否理解并信任 ADM 系统的解释,以及他们认为应该如何改进?3.2 研究设计

研究设计了一个贷款申请场景,其中银行使用随机森林模型来评估客户的信用风险,并使用 XAI 方法向客户解释贷款申请的结果。随机森林模型在训练集和测试集上的准确率分别为 0.815 和 0.8,表明模型具有良好的预测性能。

研究选择了 SHAP、DICE 和 LORE 三种 XAI 方法,并以不同的形式 (例如图表、表格、规则) 向参与者呈现。选择这些方法的原因包括:它们能够提供不同类型的解释信息 (例如全局解释、局部解释、对比解释);它们是 XAI 领域的最新方法,并具有一定的法律支持。

研究招募了 9 位法律专家参与在线问卷调查,并对其中 6 位进行了后续访谈。选择法律专家的目的是了解他们对 XAI 解释的法律合规性和可理解性的看法。

3.3 技术细节

研究使用了 South German Credit Dataset 作为贷款申请场景的数据集。该数据集包含 1000 个数据样本,每个样本有 20 个特征和一个二元响应变量 ("good vs. bad" credit)。

XAI 解释方法的计算使用了 Python 的 sklearn、SHAP 和 DICE (dice-ml) 包,以及 LORE 的开源代码。在线问卷调查使用了 Qualtrics 软件,访谈则通过 Microsoft Teams 进行,并进行了录音和转录。所有数据都进行了匿名化处理,以保护参与者的隐私。

3.4 评估细节

问卷数据经过清洗后,对参与者的自由文本回答进行了扎根理论分析。两位研究人员独立地对文本进行开放编码、轴心编码和选择性编码,最终生成了一套包含六个核心现象的编码表。访谈数据也进行了类似的扎根理论分析,最终生成了一套包含三个核心现象的编码表。

4. 结果

4.1 问卷调查结果

问卷结果分析主要围绕以下六个核心现象展开: 解释的相关性、对普通用户的可理解性、交付方式和格式的适当性、行使权利的适用性、决策结果对信息需求的意义以及信息的完整性。

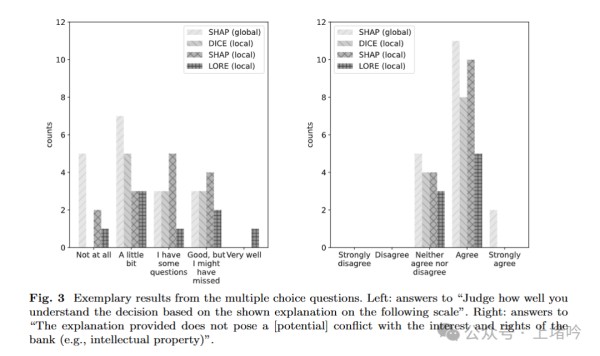

参与者对不同 XAI 方法的评价如下:

全局 SHAP:参与者普遍认为全局 SHAP 解释难以理解,缺乏与个案相关的具体信息,并且对行使权利没有帮助。局部 SHAP:参与者对局部 SHAP 解释的评价褒贬不一,一些人认为它有助于理解决策,另一些人则认为它过于复杂和难以理解。DICE:参与者对 DICE 解释的评价较为正面,认为它提供了更具体的对比信息,但同时也指出其可操作性有限。LORE:参与者对 LORE 解释的评价差异较大,一些人认为它清晰易懂,另一些人则认为它缺乏信息和指导意义。4.2 访谈结果

访谈结果主要围绕三个核心现象展开:解释的呈现、有效性以及高级主题。访谈结果显示,参与者对 XAI 解释的理解程度仍然有限,并且对解释权的范围和内容存在不同看法。一些参与者强调了解释的可理解性,认为解释应该清晰易懂,以便数据主体能够理解决策的依据。另一些参与者则更关注解释的法律合规性,认为解释应该提供足够的信息,以便数据主体能够评估决策的合法性和公平性。

4.3 相互联系与总结

研究发现,解释的有效性与其上下文密切相关,例如应用领域、决策的重要性以及适用的法律法规。此外,数据控制者和数据主体之间的利益权衡也是一个重要的考虑因素。XAI 解释需要在保护数据主体权益的同时,兼顾数据控制者的商业利益和知识产权。

总的来说,问卷和访谈的结果都表明,现有的 XAI 方法在可理解性、信息完整性和法律合规性方面仍有改进空间。

5. 讨论的关键问题

5.1 回答研究问题

在第四部分详细分析了问卷和访谈的结果之后,现在我们来解读一下研究提出的两个核心问题:

问题 1:法律专家如何理解 ADM 系统的解释,以及他们如何判断现有方法的法律合规性?研究结果显示,法律专家对 XAI 解释的理解存在一定难度,尤其是在面对 SHAP 生成的图形解释时,他们普遍感到困惑。这表明 XAI 方法的可理解性仍有待提高,开发者需要更加注重解释的清晰性和直观性。此外,法律专家对现有 XAI 方法的 GDPR 合规性也表示担忧。他们认为,许多解释缺乏关键信息,例如决策的具体依据、特征的重要性以及与个案相关的细节。这突显了 XAI 方法在信息完整性方面需要改进,以满足 GDPR 的要求。问题 2:法律专家是否理解并信任 ADM 系统的解释,以及他们认为应该如何改进?

研究发现,法律专家对 XAI 解释的信任程度并不高。他们认为,现有的解释方法难以帮助数据主体充分理解决策过程,并评估其合法性和公平性。为了改进 XAI 解释,法律专家提出了一些建议,例如:结合全局解释和局部解释,以提供更全面的信息。使用清晰易懂的语言和图表,避免使用过于专业的术语和复杂的图形。提供更多与个案相关的细节,例如特征的具体取值和对决策的影响。增加解释的交互性,允许数据主体探索不同的假设情景。

5.2 改进建议

基于研究结果, XAI 方法的开发者可以考虑以下改进建议:

呈现方式:为了提高可理解性,XAI 解释应该结合全局解释和局部解释。全局解释可以帮助用户了解模型的整体行为,而局部解释可以帮助用户理解个体决策的具体原因。此外,开发者应该使用清晰易懂的语言和图表来呈现解释,避免使用过于专业的术语和复杂的图形。例如,可以使用自然语言、决策树或简单的图表来解释模型的决策逻辑。格式选择:XAI 解释的格式应该根据用户的需求和理解能力进行选择。对于非专业用户,可以使用文本、简单的图表或决策规则来解释模型的决策过程。对于专业用户,可以使用更复杂的图形或数学公式来解释模型的内部机制。内容设计:XAI 解释应该提供足够的信息,以帮助用户理解决策过程。这些信息应该包括决策的依据、特征的重要性以及对比信息等。例如,可以使用 SHAP 方法来解释每个特征对决策的贡献,使用 LIME 方法来解释模型在局部区域的行为,使用 DICE 方法来生成对比解释。用户需求:在开发 XAI 方法时,应该充分考虑用户的需求。可以通过用户研究来了解用户的认知水平、信息需求和解释偏好。此外,可以根据用户的反馈来改进 XAI 方法的设计和实现。5.3 法律问题*

在设计和应用 XAI 方法时,还需要注意以下法律问题:

可理解性和可解释性:GDPR 要求 XAI 解释必须清晰易懂,以便数据主体能够理解自动化决策的过程,并评估其合法性和公平性。开发者需要确保 XAI 解释的语言、格式和内容都易于被目标用户理解。透明度阈值:GDPR 鼓励透明度,但也承认保护商业秘密和知识产权的重要性。在设计 XAI 解释时,需要平衡数据主体的信息权和数据控制者的商业利益。利益冲突:XAI 解释需要平衡数据主体和数据控制者之间的利益。开发者应该避免设计可能导致利益冲突的解释方法,例如,避免过度强调有利于数据控制者的信息,而忽略不利于数据控制者的信息。5.4 未来趋势

未来,参照之前的论文观点,XAI 的发展趋势可能有以下几个:

与其他技术的结合:XAI 可以与联邦学习、差分隐私等技术结合,以更好地保护数据主体的隐私和权益。例如,可以将 XAI 方法应用于联邦学习模型,以解释模型如何在不访问原始数据的情况下进行训练和决策。个性化解释:XAI 可以根据用户的需求和理解能力提供个性化的解释。例如,可以根据用户的专业背景、认知水平和信息需求,调整解释的语言、格式和内容。动态解释:XAI 可以随着模型的更新和数据的变化提供动态的解释。例如,可以将 XAI 方法与模型监控技术相结合,以便在模型的行为发生变化时及时更新解释。6. 结论

XAI 方法在 GDPR 合规性中发挥着重要的作用。它能够帮助数据主体理解自动化决策的过程,并评估其合法性和公平性,从而保障数据主体的权益。研究通过对法律专家的调查和访谈,深入了解了他们对 XAI 解释的理解、期望和顾虑。研究结果为 XAI 方法的开发和应用提供了重要的指导。

未来,XAI 方法需要在可理解性、信息完整性和法律合规性方面不断改进,以更好地满足 GDPR 的要求,并促进 AI 系统的负责任使用。

参考论文: arXiv:2501.05325v1 [cs.CY] 9 Jan 2025

本文转载自 上堵吟,作者: 一路到底孟子敬

网址:探析可解释人工智能 (XAI) 方法在 GDPR 合规性中的应用 https://www.yuejiaxmz.com/news/view/757162

相关内容

马斯克旗下xAI推出Grok应用,人工智能助手正式进入家庭生活人工智能在理财规划中的应用.pptx

智能数据应用在人工智能生活中的应用

人工智能在家具智能中的应用解决方案

人工智能用于教育领域的8种方式

人工智能在生活中的应用 人工智能在生活中的应用有哪些【详解】

浅析人工智能在智能家居系统中的应用与优化

人工智能在现代景观园林设计中的应用探究

人工智能在公司财务管理中的应用案例分析

人工智能在智能建筑中的应用