我用 Python 抓取了 7000 多本电子书

获取Python程序员的Python证书 #生活技巧# #学习技巧# #技能证书获取#

头两天神游网上,无意间发现个可以免费下载电子书的网站,一下子就勾起了我的收藏癖,心痒痒的要把这些书下载下来,正好前不久 requests 的作者 kennethreitz 出了一个新库 requests-html ,它不仅可以请求网页,还可以解析 HTML 文档,话不多说,咱开始吧。

安装

安装很简单,只要执行:

pip install requests-html

就可以了。

分析页面结构

通过浏览器审查元素可以发现这个电子书网站是用 WordPress 搭建的,首页列表元素很简单,很规整,

所以我们可以查找 .entry-title > a 获取所有图书详情页的链接,接着我们进入详情页,来寻找下载链接,由下图

可以发现 .download-links > a 里的链接就是该书的下载链接,回到列表页可以发现该站一共 700 多页,由此我们便可以循环列表获取所有的下载链接。

Requests-html 快速指南

发送一个 GET 请求:

from requests_html import HTMLSession session = HTMLSession() r = session.get('https://python.org/')

Requests-html 的方便之处就是它解析 html 方式就像使用 jQuery 一样简单,比如:

r.html.links r.html.absolute_links about = r.find('.about', first=True) about.text about.attrs about.html about.find('a')

构建代码

from requests_html import HTMLSession import requests import time import json import random import sys session = HTMLSession() list_url = 'http://www.allitebooks.com/page/' USER_AGENTS = [ "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_7_3) AppleWebKit/535.20 (KHTML, like Gecko) Chrome/19.0.1036.7 Safari/535.20", "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.71 Safari/537.1 LBBROWSER", "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/535.11 (KHTML, like Gecko) Chrome/17.0.963.84 Safari/535.11 LBBROWSER", "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E)", "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)", "Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 5.1; Trident/4.0; SV1; QQDownload 732; .NET4.0C; .NET4.0E; 360SE)", "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)", "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 (KHTML, like Gecko) Chrome/21.0.1180.89 Safari/537.1", "Mozilla/5.0 (iPad; U; CPU OS 4_2_1 like Mac OS X; zh-cn) AppleWebKit/533.17.9 (KHTML, like Gecko) Version/5.0.2 Mobile/8C148 Safari/6533.18.5", "Mozilla/5.0 (Windows NT 6.1; Win64; x64; rv:2.0b13pre) Gecko/20110307 Firefox/4.0b13pre", "Mozilla/5.0 (X11; Ubuntu; Linux x86_64; rv:16.0) Gecko/20100101 Firefox/16.0", "Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.64 Safari/537.11", "Mozilla/5.0 (X11; U; Linux x86_64; zh-CN; rv:1.9.2.10) Gecko/20100922 Ubuntu/10.10 (maverick) Firefox/3.6.10" ] def get_list(url): response = session.get(url) all_link = response.html.find('.entry-title a') for link in all_link: getBookUrl(link.attrs['href']) def getBookUrl(url): response = session.get(url) l = response.html.find('.download-links a', first=True) if l is not None: link = l.attrs['href']; download(link) def download(url): headers={ "User-Agent":random.choice(USER_AGENTS) } filename = url.split('/')[-1] if ".pdf" in url: file = 'book/'+filename with open(file, 'wb') as f: print("正在下载 %s" % filename) response = requests.get(url, stream=True, headers=headers) total_length = response.headers.get('content-length') if total_length is None: f.write(response.content) else: dl = 0 total_length = int(total_length) for data in response.iter_content(chunk_size=4096): dl += len(data) f.write(data) done = int(50 * dl / total_length) sys.stdout.write("\r[%s%s]" % ('=' * done, ' ' * (50-done)) ) sys.stdout.flush() print(filename + '下载完成!') if __name__ == '__main__': for x in range(1,756): print('当前页面: '+ str(x)) get_list(list_url+str(x))

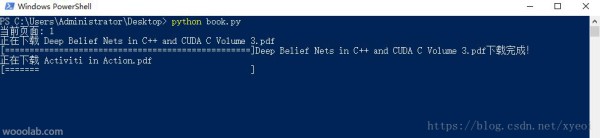

运行效果:

公众号

我的公众号喔噢实验室,欢迎交流~

网址:我用 Python 抓取了 7000 多本电子书 https://www.yuejiaxmz.com/news/view/794068

相关内容

10 个超实用的 Python 脚本!我们参观了多抓鱼「工厂」,见证一本二手书的循环生意

Python爬虫抓取基金数据分析、预测系统设计与实现——云诺说

5个实用的自动化Python脚本

占地7000平米、3天翻新一本书,神奇的二手书工厂来了解一下?丨钛媒体影像《在线》

使用Python自动下载电视节目

我为什么首选使用多抓鱼买书

我如何自动化我的生活:用于日常任务的实用 Python 脚本

五个方便好用的Python自动化脚本

【Python学习】10个Python脚本轻松实现日常任务自动化!